"Bella e fantasiosa la tua teoria, peccato che i fatti dicano altro".

A quasi mezzo millennio da Galileo, una critica del genere la sentiamo come devastante, qualsiasi sia l' argomento oggetto di dibattito.

Ormai siamo tutti degli "empiristi dentro" e quando c’ è da “quantificare” non ci fermiamo davanti a niente, nemmeno davanti alla qualità.

Oggi non fai molta strada se non hai i numeri giusti dalla tua parte, i metodi quantitativi sembrano farla da padrone e le "regole d' ingaggio" della polemica anglosassone sembrano colonizzare anche i forum continentali.

Dovendo rappresentarmi la classica diatriba, immagino due contendenti che cozzano elegantemente tra loro nella presentazione di ragioni ingegnose con tanto di allusione erudita e retorica frizzante; ad un tratto, quasi a tradimento, uno dei due rovescia ex abrupto una secchiata di "numeretti" che tramortisce l' avversario dialettico, dopodiché lascia l' agone alzando le mani in segno di vittoria e ringraziando il pubblico estasiato. Il soccombente, non appena riavutosi, corre su internet o in biblioteca alla ricerca di conforto e torna a alla carica della controparte brandendo la sua brava stringa di cifre in grado di vendicarlo. E allora giù scudisciate sulla schiena dell' avversario che sta ancora raccogliendo gli allori.

Difficile poi che i due s' interessino realmente ai numeretti dell' altro, l' importante è possederne una certa scorta da squadernare al momento opportuno.

La ricetta per l' allocazione temporale del perfetto polemista telematico si è andata via via fissando: il 5% delle risorse cognitive da dedicare all' ascolto della controparte e il 95% da dedicare alla frenetica consultazione delle proprie banche dati.

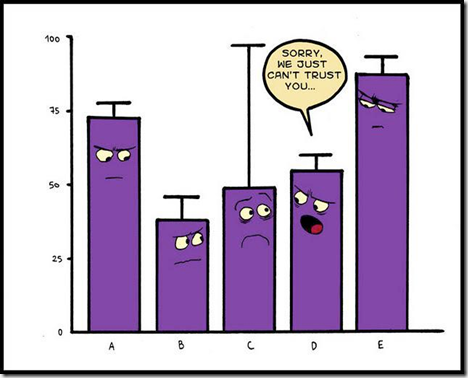

Ma i "numeretti" di cui sopra sono infidi. Come diceva quel tale, se opportunamente torturati confessano quasi sempre quel che uno vuol sentirsi dire. Ormai tutti lo sanno e non s'impressionano più di fronte ai grafici che addobbano il "nemico" come un albero di natale.

Anziché rispondere con altri grafici, molto più efficace segnalare le fallacie di quelli che ci vengono sottoposti. Ne converrete.

Ecco allora qualche consiglio che puo' venir buono quando ci troviamo in simili frangenti.

Il mio riferimento principale è agli studi statistici applicati alle scienze sociali visto che sono loro ad ingorgare le nostre giornate: ci inciampiamo continuamente leggendo il giornale o scorrendo la pagina facebook.

I motivi per circoscrivere il tutto alle scienze sociali sono essenzialmente due: 1) accolgono gli abusi più eclatanti 2) le scienze naturali sono talmente noiose che nessuno se le fila realmente (anche se bisogna far finta di farlo).

Premetto che alcune dritte le salto a piè pari: chi infatti prenderebbe mai alla lettera un titolo di giornale? Spero che non ci sia bisogno di sprecare un' avvertenza su cose che fanno parte dell' equipaggiamento minimo di chi vuol sopravvivere nel Terzo Millennio.

Cerco di sfrondare il discorso anche da altri suggerimenti scontati: inutile allora ripetere che "correlazione" e "causa" sono fenomeni differenti, che le prime potrebbero anche essere "spurie", che se uno studio ci dice che il posto in città dove crepa più gente è l' Ospedale cio' non significa necessariamente che sia un posto pericoloso da cui stare alla larga.

Sono consigli utili ma sarebbe come ricordare al chirurgo di lavarsi le mani prima di entrare in sala operatoria.

Veniamo allora a qualcosa che di solito si tralascia.

1) Innanzitutto due parole sulla funzione degli studi statistici: non servono a formarsi un'idea sul fenomeno oggetto dello studio. Strano ma vero.

E' la stessa teoria delle probabilità a metterci sull' avviso. Una prima idea sui fenomeni studiati dobbiamo formarcela pensandoci su per conto nostro, a prescindere da qualsiasi studio statistico. Probabilmente non dobbiamo nemmeno pensarci su, ce l' abbiamo già chiara in testa.

La partenza è sempre soggettiva. La conoscenza comincia sempre da un' introspezione. Non siamo una tabula rasa, dentro di noi c' è già un germe di sapere induttivo, analogico, metaforico ecc., dobbiamo tirarlo fuori e chiarificarlo a noi stessi fissando delle credenze a priori.

Poi, a posteriori, aggiorneremo queste credenze sulla base degli studi visionati e del peso che decidiamo di attribuire loro.

Cio' significa che uno studio che corrobora l' idea di Giovanni piuttosto che quella di Giuseppe, non sta dando ragione a Giovanni, sta solo chiedendo a Giovanni e Giuseppe di aggiornare le loro credenze in un senso favorevole a Giovanni.

Tuttavia, tutto cio' resta perfettamente compatibile col fatto che la ragione stia dalla parte di Giuseppe.

Il matematico italiano Bruno De Finetti ha dedicato una vita a sondare la base soggettiva di ogni calcolo probabilistico. Il cercatore di verità è uno scommettitore che parte dalle sue sensazioni correggendole con le informazioni oggettive che raccoglie via via.

2) Se la materia è complessa non soffermatevi mai su un singolo studio.

E' bene che il profano si concentri unicamente sui cosiddetti meta-studi, ovvero su quei lavori che passano in rassegna la letteratura scientifica disponibile su un certo tema per trarne, con certe tecniche di uso comune, delle conclusioni generali.

Penso si tratti di un consiglio utile poiché da solo basta a giustificare l' accantonamento del 98% di cio' che riportano i giornali, quasi sempre ossessionati dallo studio singolo.

3) A proposito di “aggregazione” dei risultati. Spesso ci si dimentica che in statistica i risultati sono difficili da “sommare” e anche la proprietà transitiva è alquanto ballerina.

Mi spiego meglio con una storiella:

Un mio amico frequentava un club tre giorni alla settimana. Era alla ricerca di un' anima gemella, ma la voleva dal carattere dolce. Sapeva che al martedì scegliere una bionda aumentava le possibilità di una compagnia con queste caratteristiche. Il Giovedì i frequentatori cambiavano completamente, ma dalle meticolose indagini fatte, la dolcezza continuava ad essere una prerogativa delle bionde. Il mio amico si comportava di conseguenza.

La domenica sera al club affluivano tutti, sia le clienti abituali del martedì che quelle del giovedì. Il mio amico nei fine settimana è particolarmente malinconico, senta avvicinarsi una nuova serie di giorni lavorativi che lo strazieranno; più che mai ha bisogno di dolcezza. Per non perdere il suo tempo dietro la persona sbagliata consulta i suoi appunti e si accorge con sgomento che per avvicinare il suo obbiettivo è molto meglio che si dedichi alle more.

La situazione di cui sopra illustra un' illusione statistica molto più comune di quanto si pensi. Ricordo di esperimenti sui farmaci che, separatamente, segnalavano l' efficacia delle medicine testate. Senonché, riunendo gli esiti si notava come l' effetto placebo fosse predominante.

L' inghippo non è immediato ma neanche difficile da cogliere. Ci si mette sulla strada se si considera che la probabilità è una frazione, e sommare numeratori e denominatori non equivale certo a sommare frazioni. Non basta considerare la misura di una probabilità ma anche quanto una probabilità incide sull' altra qualora si sommino. Una probabilità puo' essere molto alta ma avere impatto nullo se sommata ad una probabilità bassa ma “solida”.

3) Trascurare gli studi che indagano la relazione isolata tra due variabili.

Molto più serio prestare attenzione a quegli studi a cui è sotteso un modello, e quindi anche un insieme di relazioni che vanno verificate contemporaneamente.

4) Il consiglio che segue lo traggo dalla mia personale esperienza di lettore.

L' efficacia educativa dei bambini è un tema che mi è sempre stato caro e che ho sempre cercato di seguire; per una vita i relativi studi in materia hanno evidenziato vari effetti più o meno "robusti".

Tuttavia, quando si è potuto tenere sotto osservazione i soggetti del campione per periodo più lungo, ci si è accorti che la gran parte di quegli effetti correttivi dell' educazione svaniva: la nostra natura è "flessibile", ci pieghiamo ma quando lo stimolo cessa tornano anche le cattive abitudini.

Evidentemente il tempo di osservazione è decisivo. In talune tematiche, per esempio quelle legate all' efficacia educativa, i cosiddetti follow up devono essere come minimo decennali.

Nel caso specifico a cui ho accennato non c' è stata malafede, si è trattato solo di una scoperta che ha apportato rettifiche devastanti ai risultati pregressi. Ma in altri casi l' "ingenuità" diventa "trucchetto", ed ecco che il ricercatore "ferma" l' esperimento al momento opportuno pur di ottenere l' esito "desiderato".

5) Un altro trucco consiste nel dividere in tanti piccoli sottogruppi la popolazione osservata (splitting). Magari la relazione che cercate non si presenta sull'intera popolazione, magari non si presenta nemmeno per la stragrande maggioranza dei piccoli sottogruppi. Difficile però che non si presenti proprio per nessuno, almeno un piccolo sotto-gruppo sperduto nel campione generale reagisce positivamente.

E' per questo che talune medicine vengono ritenute inefficaci ma - guarda caso! - funzionano per le... donne ispaniche obese di mezz'età.

Meglio che niente, direi. Si puo' sempre fare il titolo: "Trovata la ricetta contro la sindrome xy nelle "donne ispaniche obese di mezz'età". Diffidare allora di risultati tanto specifici, probabilmente a monte c' è uno splitting sospetto.

6) C' è poi il trucco dei denominatori, tipico quando si misura, per esempio, l' efficacia delle terapie contro la dipendenza da sostanze.

Perché le cure serie danno risultati tanto deludenti (20-25% di riabiltazione) mentre alcune comunità miracolose hanno successi che rasentano il 60%?

Semplice, poiché gran parte delle defezioni si presentano all' inizio, quando la terapia viene presentata al paziente che l' abbandona ritenendola troppo onerosa, basta spostare di poco l' inizio dell' intervallo convenzionale di osservazione del trattamento, in modo da escludere dal computo i primi rinunciatari.

In questo modo le percentuali miracolose fioccano. Ma una terapia è buona anche e soprattutto se il paziente è invogliato a sottoporvisi!

7) Gran parte degli studi statistici delle scienze sociali vorrebbero dimostrare che esiste un collegamento tra due o più eventi. Per esempio: "se adottate un certo stile educativo, vostro figlio avrà successo nella vita".

A questo punto per per dimostrare la tesi bisogna trasformare la "storiella" di questa relazione in numeri, possibilmente in numeri conservati in banche dati da cui poter attingere. Ma, a parte la disponibilità delle banche dati, i veri problemi incominciano ancora prima, nella traduzione della storiella in variabili quantitative. Per farlo bisognerà adottare delle proxy.

Scegliere le proxy è un' operazione tutt' altro che innocente, si parla comunemente di "specificazione".

Troppo spesso la specificazione è problematica e difficilmente traduce in modo fedele la storiella che a noi interessa e che finirà sui titoli dei giornali. Cosa significa per esempio "avere successo"? Significa avere un reddito medio tra i 30 e i 60 anni più alto di X? Oppure avere una vita lunga almeno Y e priva di malattie? Oppure rispondere 10 quando ci viene chiesto in un certo momento quanto siamo felici da 1 a 10?

Il problema della specificazione è tra i più ostici, ma spesso passa inosservato al lettore che si limita a leggere sul giornale o nell' abstract la "storiella" della relazione ricercata e gli esiti della ricerca accantonando tutti i problemi di "traduzione" della qualità in quantità.

Lo statistico Edward Leamer ha dedicato una vita a lanciare l' "allarme specificazioni" presso gli economisti raccogliendo molti riconoscimenti e poco ascolto: si è andati avanti esattamente come prima.

8) Un tipico trucco utilizzato dietro le quinte da ricercatori dalla dubbia deontologia consiste nel moltiplicare le proxy di un fenomeno per poi scegliere quelle che presentano una relazione statistica significativa.

Vi faccio presente che se uno spende un anno su una ricerca e alla fine non "dimostra" nulla potrebbe anche pagarla in termini di popolarità e di carriera.

Sono pochi i giornali che pubblicano ricerche prive di relazioni significative. Insomma, l' onestà costa cara in questo campo, e così in molti si "danno da fare", magari con la moltiplicazione delle proxy.

9) Tutti i ricercatori hanno un sogno, ovvero poter dire: "... il seguente studio dimostra che esiste una relazione significativa tra X e Y".

Ma attenzione, la "significatività statistica" è solo una convenzione, equivale a dire che la probabilità di ipotesi nulla (inesistenza di alcuna relazione tra X e Y) calcolata sulla base dei dati raccolti è inferiore al 5% (1% in alcuni casi).

Nel valutare uno studio "significativo" il lettore profano deve allora tenere a mente due cose: 1) cosa vuol dire il termine "significativo" e 2) ricordarsi che ci riferiamo a mere convenzioni.

Per quanto riguarda il primo punto va detto che la significatività indica solo che esiste (in termini probabilistici e con tutti i limiti di cui ai punti precedenti) una relazione tra le variabili considerate e non invece che esiste la relazione così come la individua lo studio stesso dando un valore ai parametri delle equazioni.

Per quanto riguarda il secondo punto, va ricordato che "significatività statistica" non significa "significatività sostanziale".

Per esempio, molti studi "statisticamente significativi" sono carta straccia per fungere da base a certe decisioni concrete poiché adottarli come base decisionale sarebbe razionalmente troppo costoso in termini di rischio. D' altro canto alcuni studi statisticamente "insignificanti" possono fornire al decisore utili indicazioni (sul punto si è esercitata Dreidre McCloskey nel classico "The Cult of Statistical Significance: How the Standard Error Costs Us Jobs, Justice, and Lives").

10) Esiste uno standard qualitativo minimo per i lavori scientifici che vogliono dire qualcosa nell' ambito problematico delle scienze sociali, uno standard che via via si aggiorna.

Sarebbe del tutto inutile prendere in considerazione studi redatti con vecchie metodologie, almeno quando ne esistono di più accurati.

Oggi lo standard minimo richiede per lo meno l' impiego dei cosiddetti random trial, una procedura impiegata nei test medici e poi importata anche nelle scienze sociali. Meglio stare all' erta leggendo lavori privi di "random trial", io non li prenderei nemmeno in considerazione.

In poche parole, per vedere se un "trattamento" è efficace lo somministriamo ad alcuni gruppi di persone da confrontare poi con altri gruppi di persone. Tuttavia, molte variabili potrebbero interferire inquinando le valutazioni, è decisivo allora che i gruppi siano selezionati casualmente, solo in questo modo le interferenze si neutralizzano tra loro.

Ma non sempre è facile "selezionare a caso". Se stiamo valutando quanto è efficace sussidiare un villaggio africano in un certo modo, per esempio, noi possiamo controllare gli effetti facendo un confronto con gli altri villaggi ma poiché una selezione casuale è difficile, cio' puo' comportare problemi tecnici.

Inoltre, applicare il random trial conduce anche a problemi etici: perché sussidiare il villaggio X e far languire il villaggio Y? Solo per tracciare una statistica?

Si tratta di limiti a volte comprensibili ma che minano l' affidabilità dello studio.

11) Nelle scienze sociali uno studio affidabile dovrebbe sempre essere "cieco".

In altri termini, dovrebbe neutralizzare l' effetto placebo. In medicina tutti sanno cos' è l' "effetto placebo" e tutti sanno come neutralizzarlo: qualora sia il paziente trattato col medicinale in prova sia quelli non trattati ignorino la loro condizione, l' effetto placebo sarà neutralizzato.

Forse non tutti sanno che l' effetto placebo disturba pesantemente anche le scienze sociali: se forniamo ai contadini di un certo villaggio un' attrezzatura moderna che, per fare confronti sull' efficacia del nostro aiuto, neghiamo ai contadini degli altri villaggi, la produttività dei primi si distaccherà da quella dei secondi spesso anche solo per mere motivazioni psicologiche. Sembra strano ma è così.

Certo che in casi come il precedente e molti altri nell' ambito delle scienze sociali è ben difficile "accecare" lo studio. Esistono allora dei "coefficienti placebo" in grado di tarare i vari studi "non-blind". Meglio che niente.

In ogni caso, evitare quegli studi che perdono di significatività dopo l' applicazione del coefficiente. Ed evitare anche quelli che non lo applicano laddove esiste.

12) Il sogno di ogni ricercatore è "pubblicare".

Solo che difficilmente una rivista scientifica pubblicherà mai studi con risultati banali. E purtroppo, specie nelle scienze sociali, gli studi seri conducono quasi sempre a risultati banali. Si potrebbe dire che il buon senso anticipa la ricerca, e la cosa è estremamente seccante per un ricercatore con tanta voglia di emergere.

Ecco allora la tentazione di cestinare i risultati banali per presentare all' editore solo i risultati singolari.

Prova e riprova, da qualche parte un risultato originale lo si tira fuori.

Il cosiddetto "pubblication bias" spiega perché fiocchino a questo modo studi con conclusioni tanto contro intuitive: probabilmente a monte c' è molto materiale cestinato!

Chiunque vede che questo non è un modo onesto di agire, un risultato singolare ha valore solo se accostato ai tanti risultati banali ottenuti in precedenza. Solo in questo modo, infatti, noi avremo un' immagine fedele di come stanno le cose.

Ebbene, anche qui esistono dei coefficienti di "publication bias" che fanno la tara agli studi, sono necessariamente imperfetti ma sarebbe meglio applicarli.

Quando leggete uno studio sul rapporto uomo-donna, per esempio, meglio chiedere: i risultati sono al netto del coefficiente di "publication bias" caratteristico degli studi di genere? No? Ah, allora grazie e arrivederci.

13) Dimenticavo, chiedersi sempre: il campione è adeguato?

14) Non dimentichiamo mai la cosiddetta critica di Lucas: nelle scienze umane, specie nell' economia, l' individuazione di una regolarità statistica è la premessa affinchè cessi. Almeno se gli operatori sono razionali.

Pensate a cosa succederebbe se si scoprisse che le quotazioni di borsa si alzano sempre al Lunedì mattina

15) Occhio alla cosiddetta “casualità non rilevata”.

Tirando la classica moneta una sequenza CTCTCCTT ci appare come casuale mentre una sequenza CTTTTTTT ci appare come pilotata. Eppure entrambe le sequenze hanno la medesima probabilità estrattiva.

16) Ci sono fatti che reputiamo sorprendenti e sintomatici quando invece sono del tutto normali.

Penso per esempio alle regressioni verso la media. E' un fenomeno naturalmente sottostimato.

Prendiamo una gara articolata su due manches. I migliori nella prima tornata peggioreranno sicuramente la loro prestazione media nella seconda. Altro esempio, prendiamo delle coppie di coniugi e valutiamo i mariti per la loro preparazione culturale. Isolando i più preparati e passando poi a considerare le mogli ci rendiamo conto che la prestazione di queste ultime non è, nell' insieme relativo alle mogli, all' altezza di quella dei corrispondenti mariti nell' insieme che li riguarda. Ci sorprendiamo di questo fatto nonostante sia del tutto naturale.

17) Sarà banale dirlo ma i conflitti d' interesse indeboliscono a priori la credibilità di uno studio.

Naturalmente la cosa migliore sarebbe approfondire tutti gli studi per evidenziarne pregi e difetti.

Tuttavia, data l' abbondanza di ricerche disponibili, io direi di scartare quelli curati da chi si presenta un conflitto d' interesse materiale ma soprattutto ideologico.

Da cattolico, per esempio, cerco di evitare gli studi condotti da associazioni cattoliche in materia di, che ne so, aborto o adozioni gay.

Ma questo principio vale per tutto e per tutti.

Un conflitto spesso valutato è quello che interessa gli istituti di ricerca statali (Università ecc.). Lo stato è un finanziatore che, come tutti i finanziatori gradisce certi risultati, per esempio quelli che gli consentono di allargare la sua sfera di influenza.

E' così raro trovare ricerche indipendenti.

18) Ho tenuto per ultimo il consiglio che ritengo più importante e che puo' anche essere visto come un affinamento del primo punto.

Dicevamo che il classico studio statistico pretende di illustrare l' esistenza di una certa relazione tra due fenomeni; gli esiti vengono poi spesso presentati in termini probabilistici al fine di enfatizzarne la plausibilità.

Piccolo - e infido - particolare: la probabilità intrinseca nello studio andrebbe ulteriormente pesata (e quindi ridotta) con la probabilità che uno studio del genere sia replicabile ottenendo i medesimi risultati.

[... partiamo da una semplice considerazione: volendo sapere se una moneta è truccata, la lancio due volte in aria ottenendo due volte "testa". Cosa ne deduco? La probabilità di avere un risultato del genere con una moneta regolare è del 25% ma cio' non implica certo che la probabilità di avere in mano una moneta truccata sia del 75%!...una regressione collega un' evidenza disponibile (E) ad un' ipotesi di lavoro (I) stabilendo una relazione (R) tra i due fenomeni. Per convenzione, si dice che questa relazione sia "statisticamente rilevante" quando la probabilità dell' ipotesi nulla (N) è inferiore al 5% (in alcuni casi dell' 1%). L' ipotesi nulla è l' ipotesi per cui non esiste alcuna relazione tra I ed E. Nel caso precedente, se ipotizziamo una moneta truccata, l' ipotesi nulla è che la moneta sia regolare. Diciamo che se p (N dato E) minore di 5, allora la relazione R è rilevante. Ma attenzione, dire che p (N dato E) minore di 5 non significa dire che p(E dato N) sia minore di 5! Le due probabilità non sono affatto collegate in modo così immediato, sono invece messe in relazione dalla probabilità che l' esperimento possa essere ripetuto, ovvero da una probabilità soggettiva espressa di solito con la frazione pE/pN. In ogni lavoro statistico questa probabilità a priori è ineliminabile: noi potremmo anche - in teoria - ripetere l' esperimento ma l' esito andrà di nuovo pesato da un "coefficiente di ripetibilità". Le regressioni, allora, non fissano delle probabilità assolute, come sembrerebbero far capire talune divulgazioni. Per questo motivo il reverendo Thomas Bayes diceva quello che noi abbiamo umilmente tentato di dire al primo punto: la regressione non stabilisce ma aggiorna delle probabilità a pre-esistenti, che sono sempre soggettive... ]

19) Con uno studio statistico davanti, spesso il nostro cervello soffre e si prende una vacanza. Capita che sopravvaluti certi aspetti ma altrettanto spesso che ne sottovaluti altri. Alcuni concetti cominciano curiosamente a distorcersi.

Pensiamo al caso del concetto di “vita umana” e del suo significato. Noi tendiamo a sacralizzare La vita umana e a trascurare Una vita umana.

In certi contesti la vita umana non ha prezzo, in altri contesti (quelli statistici) ci riteniamo curiosamente autorizzati alla sprezzatura.

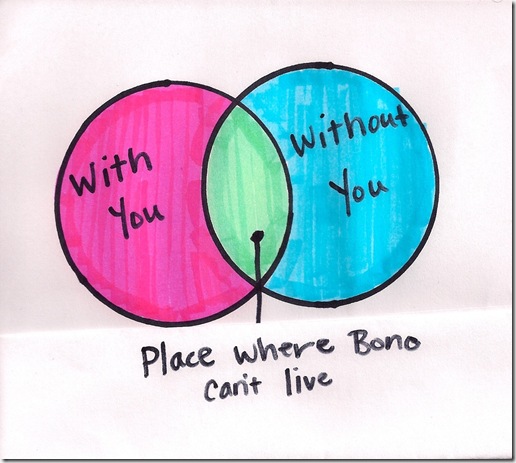

Lo notava Thomas Schelling quando si chiedeva come mai nella sensibilità sociale sarebbe disumano non sganciare 1 milione di euro per salvare Alfredino Rampi incastrato nel pozzo mentre l' istallazione di un guard rail sull' autostrada che salverebbe in media una vita all' anno, non ci coinvolge per nulla e decliniamo la proposta compiaciuti del risparmio.

Se imparassimo a leggere meglio le statistiche, forse potremmo correggere asimmetrie di questo genere.

20) Dopo la serie di avvertenze fornite, molti saranno tentati dallo scetticismo, diranno "lasciamo perdere uno strumento tanto infido".

Errore! Innanzitutto prevedo che per molti una conclusione del genere non sia sincera ma solo un pretesto per sdoganare la propria pigrizia: fare le pulci a uno studio statistico è faticoso, liquidarli tutti in blocco per affidare la difesa di una tesi all' improvvisazione retorica lo è molto meno.

In secondo luogo, difendo la rilevanza delle piccole probabilità.

Quando tutto equivale, anche una tenue quanto problematica correlazione puo' essere decisiva nel far pendere il piatto della bilancia. Siamo scommettitori razionali e a parità di posta siamo tenuti a seguire anche le indicazioni di una differenza probabilistica invisibile.

Nell' ambito delle scienze umane, i saggi più convincenti che ho letto mescolavano abilmente introspezione, senso comune, esperienza personale, statistiche e storia. La statistica non veniva mai schifata; anzi, aveva un posto d' onore. Volete un esempio? Il mio preferito è quello fornito da Milton Friedman e Anna Schwartz: A Monetary History of the United States, 1867–1960

AGGIUNTE POSTUME

ADD1. R = relazioni vere / relazioni possibili. Ogni oggetto di studio ha un suo R, quanto più questo valore è elevato tanto più probabile che le conclusioni raggiunte negli studi saranno false. Si chiama "indice di comparabilità" e rappresenta un modo di far entrare in scena Bayes, infatti l' indice di comparabilità di un settore di ricerca rappresenta la probabilità a priori che la relazione da testare sia vera (sul punto vedi il lavoro di John P. Ioannidis).

ADD2. Sul buon uso dello strumento statistico nelle scienze sociali. Consigliabile l' utilizzo per negare conclusioni apodittiche altrui, oppure per revocarle in dubbio. Evitare l' utilizzo per "dimostrare" alcunché.

ADD3. Sull' utilità della storia nelle scienze sociali. Riguardo al progresso delle scienze sociali di solito si fronteggiano 3 posizioni:

- Il meglio del passato è incorporato nel presente, il sapere si accumula;

- Il presente dimentica il meglio del passato e degenera;

- Vale la pena di studiare la storia perché molto di buono puo' essere tralasciato.

Solo la terza posizione implica lo studio fruttuoso della storia, la prima lo esclude.

Se la prima posizione è sensata per le "scienza dure" non sembra esserlo per le scienze sociali. Queste ultime sono troppo esposte all' ideologia e alla politica, e se a questo aggiungiamo che sono particolarmente vulnerabili alla critica del teorema di Duhem-Quine, capiamo come possano procedere a lungo in modo distorto.

ADD4. Legge di Goodharth: quando il governo elabora un suo programma sulla base di statistiche attendibili quelle statistiche smettono di essere attendibili.

ADD5 leggge di ip: in un mondo sempre più sicuro aumenta l'intensità delle catastrofi e la loro rarefazione. guardare alla storia recente perde progressivamente di senso, ma questo è proprio cio' che fanno le statistiche. vedi greg ip

ADD6 Superforecasting: The Art and Science of Prediction di Philip Tetlock, Dan Gardner

ADD4. Legge di Goodharth: quando il governo elabora un suo programma sulla base di statistiche attendibili quelle statistiche smettono di essere attendibili.

ADD5 leggge di ip: in un mondo sempre più sicuro aumenta l'intensità delle catastrofi e la loro rarefazione. guardare alla storia recente perde progressivamente di senso, ma questo è proprio cio' che fanno le statistiche. vedi greg ip

ADD6 Superforecasting: The Art and Science of Prediction di Philip Tetlock, Dan Gardner

- bill flack è un superforecaster. come lui ce ne sono altri.

- domande tipo a cui risponde un s.: la russia annetterà i territori ucraini entro tre anni? l india entrerà nel consiglio di sicurezza onu tra un anno? quali paesi abbandoneranno l euro nei prossimi 5 anni?

- scopo del libro: spiegare il modus operandi dei s. e xchè sono tali.

- xchè bill nn è un editorialista del nyt?

- nn lo sappiamo xchè nn abbiamo un track record degli editorialisti solo opinioni su opinioni ma vaghe nn testabili. tipo: se la nato aprirà all india la russia reagirà esponendoci ad una nuova guerra fredda.

- ci interessa di più sapere se la juve ha fatto un buon acquisto o sapere se ci sarà un genocidio in sud sudan? sembrerebbe che la juve ci stia molto più a cuore.

- s. ha delle qualità che possono essere coltivate da tutti.

- l esperto prevede come una scimmia coi dadi? la ventennale ricerca di tetlock sfiora qs paradosso ma dice anche qlcs di più costruttivo..

- l esperto fa un pochino meglio del profano

- solo l orizzonte 3/5 anni lo fa diventare scimmia

- gli eclettici fanno meglio degli specialistici.

- dobbiamo fidarci dell esperto? coltiviamo uno scettico ottimismo.

- xchè scetticismo? prendi la primavera araba nasce con una storia come tante. avrebbe potuta succedere l anno prima. facile da razionalizzare ma difficile da prevedere.

- quante cose può fare il battito d ali di farfalla!

- teoria del caos: nella simulazione pc di sistemi complessi basta variare di poco un dato e gli esiti s invertono.

- laplace: più sappiamo più sapremo prevedere. se sappiamo tutto del presente sapremo tutto del futuro: il mondo è un orologio. meccanicismo

- lorentz: no il mondo è una nuvola. i feedback radicali ci espongono a variazioni infinitesimali. non sapremo mai come evolve una nuvola.

- paradosso: oggi gli scienziati sanno di più ma sono più scettici sulle previsioni...

- complessità: legge goodheart/lucas: la realtà cambia nel momento stesso in cui viene prevista. x i siatemi instabili la previsione è impossibile. x altri viene a dipendere dalle farfalle ed è quindi difficile. altri sistemi sono più stabili.

- xchè allora ottimismo? xchè ci sono cose che si possono prevedere. x es. se ci sará traffico x andare al mare...

- le assicurazioni fanno molti soldi prevedendo con successo un mondo complesso...

- il mondo è un misto di orologi e nuvole tutto è prob e margine d errore..

- track record. essenziali x migliorare ma anche poco adottati. forse prevale lo scettico/scettico.

- pochi rivelano l accuratezza e quasi nessuno giudica l esperto in base a quella..

- il problema della domanda: pochi chiedono conto delle evidenze...

- poca misurazione poca revisione pochi miglioramenti.

- distinguiamo: previsione x migliorare la conoscenza. previsione x divertirsi. previsione fatta x autoavverarsi. solo le prime due richiedono misurazione.

- ci sono anche p. fatte x impressionare: il superconsulente o il supereditorialista. anche qui il r.t. è inutile.

- altre confortano il militante come un bagno caldo. niente rt ovviamente.

- ottimismo: conoscendo tante distorsioni sappiamo dove migliorare.

- torneo: 5 squadre che x 4 anni rispondono a una domanda al giorno su affari e politica con una p. il metodo è libero.

- il gruppo dei superf. batte tutti il gruppo di controllo come il gruppo accademici.

- conclusione 1: la capacitá previsionale esiste ed è misurabile e nn si identifica con la potenza accademica...

- conclusione 2: la capacità p. nn è un talento ma un modo di pensare. un modo di aggiornare le proprie credenze.conoscere la differenza tra 60/40 e 40/60. l esperto conosce i nessi ma il superf sa pesarli.

- xchè progressi tanto lenti? psicologia: crediamo di conoscere quel che nn conosciamo (x esempio se panebianco è un buon p.).

- la differenza nn la fa l ideologia. nn la fa nemmeno l accesso ai dati e nemmeno l intelligenza. la matematica nn viene mai usata. il s. nn è uno sgobbone. conta COME si pensa.

- il s. è autocritico. sa correggersi. vuole migliorarsi. qs significa che è curioso e aprrto.

- classifica 1 s. 2 algoritmo statistico 3 esperto 4 persona comune.

- ma l algoritmo affidabile è raramente disponibile x il problema da affrontare al momento. i problemi cambiano sempre e basta una leggera differenza per rendere dannoso l algoritmo a disposizione

- intelligenza artificiale: nel 65 sembrava prossima. oggi siamo più cauti.

- il s. del futuro: un uomo col pc. l uomo fa sintesi della complessità che manda in palla un pc. il pc corregge i bias dell uomo

continua

ADD7 Why Most Published Research Findings Are False di John P. A. Ioannidis

- la probabilità p di una relazione r dipende da:

- 1 p a priori di quella r

- 2 ampiezza del campione

- 3 ampiezza dell effetto

- 4 numero di modelli plausibili

- 5 flessibilità di specificazioni e design

- 6 ideologia e interessi coinvolti

- 7 la moda di un argomento

- rimedi:

- 1 fidarsi solo delle meta analisi

- 2 trascurare stat sign e privilegiare bayes, ovvero R

- R=rapporto tra relazioni vere/replicate e relazioni possibili in un certo ambito (p a priori che la relazione testata sia vera)

continua

ADD8 The cult of statistical significance di Dreirde McCloskey

ADD8 The cult of statistical significance di Dreirde McCloskey

- Significato statistico ss vs. Significato economico se

- Tesi: ss nn ha la capacità di guidare l azione pratica.

- Ss nn è un concetto scientifico

- L eroe del libro: william gosset. La sua lotta contro ronald fischer.

- Appello: tornare a bayes. Recuperare il soggettivo contro la convenzione pseudo-oggettiva.

- In filosofia il problema del quanto ha sostituito quello dell esistenza ma con il p value torniamo a concentrarsi solo sull'esistenza. in passo indietro

- Ss prevale sul size effect. co quello che resta in testa. anche se magari il rischio di cancro è compensabile bevendo un bicchiere di vino in meno al mese

- Ss prevale sui test economici di gosset.

- Attraversare la strada x salvare il tuo bimbo è un conto. Farlo x acquistare la mostarda un altro. Anche se le prob. di fare incidenti è lo stesso.

- La difesa di ds: è rigorosa. Serve x scremare le pubblicazioni. È una mera convenzione.

- Così facendo lo statistico si trasforma in un esperto lontano da qls problema concreto.

- Alternativa a ss: best practice.

- Elenco delle topiche imputabili a ss

- L economia è migliorata dopo ss?

- I prof ribelli: leamer savages zellners grangers.

- I guai di ss in psicologia e in medicina.

- Medicina. La rivolta di kenneth rothman e della sua rivista epidemiology.

- 80 anni di raffinata inutilitá. Come è potuto accadere? Interessante questioe x l epistemologia.

- Alternative: simulazioni al pc

- Alternative: coefficienti che abbinano size e ss. probabilmente non segnalerebbero pericolo nel caso delle carni rosse

- Alternative: scommesse. il recupero del soggettivo e di bayes

conclusioni

ADD9 The great statistical schism di Brendon Brewer

- cos'è la probablità? due scuole. tesi: ha vinto il peggio

- beyesiani conta la probabilità a priori per pesare i risultati

- frequentisti: conta cio' che si osserva, basta fingere che esperimenti uguali siano ripetibili

- per i f un risultato è statisticamente significativo se p value inf. al 5%

- ma un p inf al 5% non significa che la prob della relazione sia del 95%, sarebbe così solo se il laboratorio immaginario in cui gli esperimenti sono sempre ripetibili coeteris paribus fosse reale

- un problema esemplificativi: hai due medicinale che potenzialmente curano la stessa malattia A e B e due gruppi omogenei di 100 malati ciascuno. A ne guarisce 70 mentre B 83. Quante possibilità ci sono che A e B siano ugualmente efficaci?

- frequentista: analogia: se tiro una moneta 10 volte che prob ci sono esca testa solo 1 volta? e due? e tre?... 10 volte? sommo il quadrato (2 lanci) di queste prob e ottengo la probabilità di ottenere lo stesso numero. allo stesso modo posso calcolare la possibilità che su una doppia serie di 100 lanci possa ottenere 70 e 83. E' circa dello 0.0002. questo valore si chiama p-value.

- nota l'assunto: io so con certezza che la moneta non è truccata, non devo attribuire una prob a questo fatto. allo stesso modo postulo che l'esperimento di cui sopra sia ripetibile esattamente, non postulo una prob sulla ripetibilità. Il bayesiano invece non conosce eventi a cui non attribuire prob, per lui tutto è prob.

- bayesiano: devo calcolare la prob che A e B siano parimenti efficaci. Qual è la proprietà a priori di qs evento? Ammettendo che esistano due possibilità - parimenti efficaci e B più efficace di C - la prob in favore del primo, stante la mia ignoranza, potrebbe essere 0.5. Qual è la prob a priori dell' esito sperimentale? Con tutte le combinazioni possibili ammettiamo che sia intorno a 0.001. La probabilità dell'esito sperimentale, data la pari efficacia delle medicine, la so già, è il p-value 0.0002. Con questi dati e la formula di bayes posso calcolare la prob che, dato l'esperimento, i due farmaci siano parimenti efficaci: 0.11. Un valore nettamente più alto di 0.0002. in buona sostanza: il p-value è amplificato da un coefficiente costruito col rapporto delle prob a priori (0.5 e 0.001, ovvero in questo caso circa 500))

- critica a bayes: è soggettivo (le prob a priori sono soggettive)

- risposta: ma così è la realtà

- una soluzione: ecumenismo.

- problema: riluttanza ad abbandonare le vecchie idee

- analogia con la fisica: newton si insegna ancora perché propedeutico ad einstein (ovvero: più facile e introduttivo)

- ma l'analogia non vale con la statistica perché bayes (ovvero la teoria più rigorosa) è anche più semplicve rispetto al frequentismo (la teoria più lacunosa).

continua

- Ten Oh No! It’s a Girl! - More Sex Is Safer Sex: The Unconventional Wisdom of Economics by Steven E. Landsburg - #femminucceedivorzi #statusenutrimentocorporeo #whoiswhoemaschietti #nipotame #stressfemminuccegermaniaest #ilmaschietotirisposa #patrignipredatori #figliunicimaschi #ipiùrichiestinelleadozioni #splittingnelleredità #autostimaneifigliedivorzio

- Eleven The High Price of Motherhood - More Sex Is Safer Sex: The Unconventional Wisdom of Economics by Steven E. Landsburg - #famigliaecarriera #causalitàocorrelazione #abortoallastessaetà #cercatoallastessaetà #nonvolutoallastessaetà #economistieprovettesporche

- Fifteen Matters of Life and Death - More Sex Is Safer Sex: The Unconventional Wisdom of Economics by Steven E. Landsburg - #ventilatoripertutti #schellingavermicino #valoredellavitaevaloririschiosi #tuttiigiorniprezziamolavita #cellulariallaguida #blackstonetroppoprodigo #fareunastimadadoveiniziare